Una investigación demuestra que el algoritmo COMPAS, utilizado por los jueces para dictar sentencia, comete errores, tantos como un humano.

En la película “Minority Report”, la delincuencia es casi eliminada gracias a las visiones de tres mutantes con la habilidad de predecir el futuro. Esto permite a las autoridades arrestar a los criminales antes de que puedan cometer el delito. Muy lejos estamos de algo semejante, pero la justicia estadounidense sí utiliza su propio “mutante” para saber si alguien puede volver a reincidir. Se trata de un sofisticado software llamado COMPAS , una herramienta informática que ayuda a los jueces a dictar, por ejemplo, si alguien debe entrar en prisión o salir en libertad condicional, o el tiempo que debe permanecer en la cárcel, según su puntuación de riesgo de volver a las andadas.

Pero que una máquina decida sobre la vida humana siempre da lugar a controversias. Investigadores y defensores de los derechos civiles han dudado sobre su fiabilidad y temido que sus resultados sean injustos. En el caso de COMPAS, había sospechas de que el sistema favorecía a los ajusticiados blancos frente a los negros. Un equipo de investigadores liderado por Julia Dressel, estudiante de informática en el Dartmouth College, decidió salir de dudas. Ha estudiado la validez de los resultados de COMPAS, y lo que ha encontrado es de lo más inquietante. El algoritmo no es más fiable que cualquier humano sin preparación.

Dressel se dirigió a la base de datos ProPublica , una colección de puntuaciones de COMPAS para 10.000 acusados en espera de juicio en el Condado de Broward, Florida, así como también sus registros de arrestos para los siguientes 2 años.

La investigadora seleccionó al azar a 1.000 de los acusados y registró siete datos sobre cada uno, incluyendo su edad, sexo y número de detenciones previas. Luego reclutó a 400 personas a través Amazon Mechanical Turk, un servicio de crowdsourcing en línea para encontrar voluntarios de investigación. Cada voluntario, sin preparación previa y de diferentes edades y niveles educativos, recibió perfiles de 50 acusados y debía pronosticar si volverían a ser arrestados dentro de dos años, el mismo estándar que utiliza COMPAS. Los humanos acertaron casi con la misma frecuencia que el algoritmo, entre el 63% y el 67% de las veces, en comparación con el 65% de COMPAS, según informa la revista Science Advances.

Resulta que los humanos puntúan tan bien como el algoritmo cuando predicen correctamente la detención de alguien. Pero cuando se equivocan, revelan un sesgo racial similar. Tanto el hombre como la máquina supusieron incorrectamente que habría más arrestos de personas negras de lo que realmente sucedió (falsos positivos) y menos arrestos de blancos (falsos negativos).

Más sencillo, igual resultado

En un segundo experimento, Dressel exploró si un algoritmo simple podría vencer a COMPAS, que normalmente utiliza seis factores de un cuestionario de 137 puntos para evaluar el riesgo (En realidad, la mayoría de los elementos determinan qué programas de rehabilitación pueden servir a un delincuente). La investigadora creó su propio algoritmo, con solo dos factores: la edad y el número de condenas anteriores. Esa fórmula simple obtuvo predicciones correctas el 67% de las veces, similar a la puntuación de COMPAS.

En EE.UU., algoritmos similares influyen no solo en las decisiones judiciales, sino también en las aprobaciones de préstamos, las evaluaciones de los docentes e incluso si los cargos por abuso infantil pueden ser investigados por el estado. Pero saber que no son mejores que cualquiera en predecir el comportamiento de un delincuente hace que quizás deba cuestionarse su fiabilidad. La inteligencia artificial tiene un potencial enorme para ayudar a la humanidad y sus usos son extremadamente diversos, aunque a veces causan polémica.

En el caso de Japón, se determinó que algoritmos inteligentes son capaces de reconocer a potenciales criminales con solo analizar sus rostros, lo que ayudaría a prevenir delitos mucho antes de que estos sucedan.

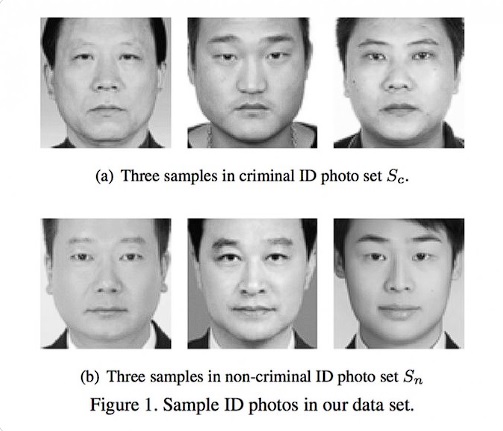

Investigadores de la Universidad de Jiao Tong, en Japón, afirman haber creado un algoritmo inteligente capaz de reconocer a potenciales criminales con solo analizar su foto, para ello se basarían en pequeños rasgos creando así perfiles.

Según sus creadores el programa computacional tiene una precisión del 90 % y para crearlo analizaron los rostros de más de 1800 personas buscando aquellas características físicas que tienen en común.

La mitad de las imágenes eran de criminales, la otra mitad de personas sin antecedentes y el programa logró separarlos en dos grupos acertando en la mayoría de los casos, por lo que creen que podría tener un rol muy útil para la prevención del delito.

Los expertos que participaron en la creación de este programa inteligente dejaron que el mismo algoritmo determinara aquellos rasgos propios de los delincuentes y que para la mayoría de nosotros serían imperceptibles.

Entre las características del rostro analizadas están la curvatura de los labios, distancia entre las esquinas de los ojos, el ángulo de la nariz con respecto a la boca, etc. La combinación de ciertos rasgos son los que hacen que el algoritmo determine que la persona en la foto es un criminal en potencia.

Por supuesto que la polémica con respecto a este estudio no se hizo esperar, ya que la muestra es demasiado pequeña para dar resultados científicamente relevantes y, podría llevar a la discriminación racial y acusaciones sin ninguna prueba.

Fuente: ABC Ciencia y UNIVISION